Data Science, Diverse, Erfolgsstories

Webcrawling Dashboard

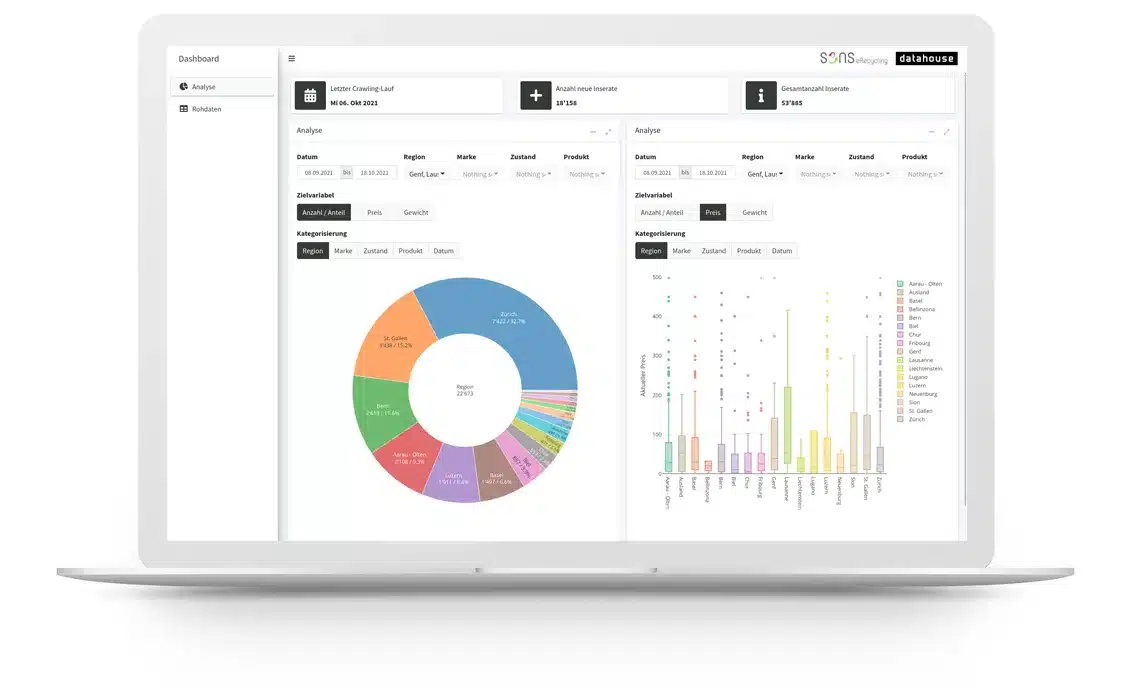

Interaktives Dashboard zur Analyse von Crawlingresultaten

vonThomas Maier

16 Apr 24

SENS möchte die Wiederverwendung von Elektrogeräten in der Schweiz verfolgen, um potenzielle Massnahmen und Entscheide datengestützt umzusetzen. Bereits wenige Wochen nach dem Kick-Off konnte SENS die ersten Datensätze auf einem massgeschneiderten Analyse-Dashboard untersuchen.

Auslangslage

SENS fördert das nachhaltige Recycling von Elektro- und Elektronikgeräten. Für SENS ist neben dem Recycling auch die Wiederverwendung von Geräten von Interesse. Um Massnahmen der Kreislaufwirtschaft gezielt zu fördern und damit wertvolle Ressourcen zu schonen, benötigt unser Kunde Hinweise zu Produkten sowie zur regionalen und saisonalen Mengenentwicklung auf dem Sekundärmarkt. SENS möchte daher Informationen zur Wiederverwendung von Elektro- und Elektronikgeräten ermitteln und analysieren.

Projektvorgehen

Für dieses Projekt wählten wir ein iteratives Vorgehen, um möglichst flexibel auf neue Erkenntnisse reagieren zu können. Dabei entwickelten wir in relativ kurzen Iterationen die entsprechende Funktionalität, die dann an einem Review-Meeting vorgestellt und besprochen wurde. Auf Basis der gewonnenen Erkenntnisse wurde jeweils die Planung für die nächste Iteration erstellt.

Am Kickoff-Meeting prüften wir mit SENS mögliche Datenquellen. Basierend auf ihren Bedürfnissen und der technischen Machbarkeit wählten wir eine geeignete Handelsplattform als primäre Quelle. In einer ersten Iteration entwickelten wir innerhalb von zwei Wochen den Webcrawler, um die relevanten Daten regelmässig abzurufen und aufbereitet in einer geeigneten Datenbank abzuspeichern. Im anschliessenden Review-Meeting wurde mit SENS die Datenqualität und die Datenaufbereitung besprochen. Zudem skizzierten wir auf Grundlage der Analyse-Bedürfnisse verschiedene Möglichkeiten für das Dashboard.

SENS plant explorative Datenanalysen durchzuführen. Hierfür wurde ein flexibler und interaktiver Ansatz für das Dashboard gewählt, damit auch neu auftauchende Fragestellungen problemlos untersucht werden können. Während der nächsten Iteration entwickelten wir innerhalb von drei Wochen das Dashboard im laufenden Austausch mit SENS, die bereits einen Testzugang erhielten, um die Entwicklung zu verfolgen. Im anschliessenden Review-Meeting diskutierten und priorisierten wir letzte Optimierungsansätze. In einer letzten Entwicklungsiteration wurde der Webcrawler und das Dashboard innerhalb weniger Wochen finalisiert.

„Datahouse hat meine Bedürfnisse perfekt abgeholt, mich laufend über den Entwicklungsstand informiert und meine Wünsche stets ernst genommen.“

Pasqual Zopp, Stv. Geschäftsführer, Leiter Back Office

Endprodukt

SENS hat exklusiven Zugriff auf ein individuelles Analyse-Dashboard. Sie können alle gesammelten Daten analysieren und nach Wunsch exportieren. Datahouse stellt den Betrieb des Dashboards und des Webcrawlers im Hintergrund sicher und überwacht kontinuierlich die Datenqualität aus den automatisierten, regelmässigen Abfragen.

Eingesetzte Technologien

Das Dashboard wurde mit dem R Shiny Framework entwickelt. Für das Webcrawling setzen wir Python Scrapy ein und unsere bewährte Spezialinfrastruktur zur Koordination und Überwachung. Alle Daten liegen in einer MongoDB Datenbank.

Mehr erfahren

Stehen Sie vor ähnlichen Herausforderungen oder haben Sie ein vergleichbares Projekt, bei dem Sie Hilfe benötigen? Dann zögern Sie nicht, unseren Senior Expert Data Scientist Thomas Maier zu kontaktieren.